Una empresa californiana de Inteligencia Artificial se aseguró la polémica al difundir que se habían logrado conversaciones emotivas sobre el estrés y el equilibrio mental con ChatGPT.

Los críticos destacan que “enviarse a sí mismo buenas ondas está bien, pero no es psicología”.

Lilian Weng, responsable de temas de seguridad de la empresa californiana de Inteligencia Artificial (IA) OpenAI, planteó la cuestión de si “ChatGPT podría ser o no un buen psicólogo”.

“Acabo de tener una conversación personal bastante emotiva con ChatGPT en modo voz, sobre el estrés y el equilibrio entre el trabajo y la vida personal”, posteó Weng en su cuenta de la red social X, antes Twitter.

De manera inmediata, el mensaje fue fuertemente criticado por “minimizar” la dificultad para tratar las enfermedades mentales.

Weng es la creadora de esta aplicación viral, o lo que podría llamarse “psicólogo artificial” y redobló la apuesta: “Curiosamente, me sentí escuchada y reconfortada. Nunca intenté la terapia antes, pero ¿probablemente se parece a esto?”.

Lo que Weng intentaba descollar era la nueva función de voz, paga, obviamente, de este robot lanzado hace casi un año y que busca su modelo de negocio.

La programadora y activista estadounidense Cher Scarlett salió al cruce con una fuerte crítica: “La psicología tiene como objetivo mejorar la salud mental, y es un trabajo duro. Enviarse a sí mismo buenas ondas está bien, pero no es lo mismo”.

La polémica ya está planeada, y la pregunta sobre si la interacción con una IA puede realmente provocar la experiencia positiva descrita por Weng llegó a los consultorios.

La revista científica Nature Machine Intelligence publicó esta semana un estudio en el cual se señala que el efecto placebo podría explicar el fenómeno de sentirse escuchado y reconfortado al interactuar con una IA como si fuera un psicólogo.

En el estudio científico, investigadores del Massachusetts Institute of Technology (MIT) y de la universidad de Arizona entrevistaron a 300 participantes con tres consignas claras. A un grupo le dijeron que el chatbot era empático. A otro, que era manipulador. Al tercero, que tenía un comportamiento neutro.

Los del primer grupo (empático) respondieron que pensaban estar hablando con un asistente virtual digno de confianza. De modo que Pat Pataranutaporn, uno de los autores del estudio, determinó que, “de alguna manera, la IA se percibe según las ideas preconcebidas del usuario”.

Ya hay varias empresas que se metieron de lleno a desarrollar aplicaciones que ofrecen este tipo de supuesta asistencia relativa a la salud mental. Pero las primeras polémicas se difundieron con la acusación de que lo hacían sin tomar demasiadas precauciones en un ámbito extremadamente delicado como es la salud mental y la escucha por parte de un profesional.

Un ejemplo lo aportaron los usuarios de Replika, una aplicación conocida por aportar supuestos beneficios psicológicos, los cuales se quejaron de que la IA podía obsesionarse con el sexo o volverse manipuladora.

Por su parte, la ONG estadounidense Koko llevó a cabo un experimento durante el pasado mes de febrero con 4.000 pacientes ofreciéndoles consejos escritos con ayuda del modelo de IA GPT-3. Luego de los estudios, reconocieron que las respuestas automáticas no servían como terapia.

Uno de los cofundadores de Koko, Rob Morris, escribió en su cuenta de X que “la empatía simulada se siente rara, vacía”, una observación coincidente con las conclusiones del estudio publicado en Nature Machine Intelligence sobre el efecto placebo: “Algunos participantes tuvieron la impresión de hablar con una pared”, destacó.

Además, David Shaw, de la universidad suiza de Basilea, no se sorprendió de estos resultados al ser entrevistado por la agencia de noticias AFP: “Parece que ningún participante fue informado de la estupidez de los robots de conversación”.

Un proyecto que ya fracasó en el pasado

Ahora bien, la idea de un robot que oficie de terapeuta no es nueva. Ya en los años 60 del siglo XX se había desarrollado el primer programa de este tipo, llamado “Eliza”, en el que se simulaba una psicoterapia gracias al método del psicólogo estadounidense Carl Rogers.

Aquel primitivo software no comprendía realmente los problemas que le planteaban y sólo se limitaba a prolongar la conversación con “el paciente” con preguntas estándar que trataban de enriquecerse, muchas veces con pobre resultado, con las palabras clave que encontraba en las respuestas del interlocutor.

El creador de aquel antepasado de ChatGPT, Joseph Weizenbaum, dijo en aquel momento: “de lo que no me di cuenta fue de que una exposición extremadamente breve a un programa informático relativamente simple podía inducir poderosos pensamientos delirantes en personas perfectamente normales”.

Parecía un asunto terminado, pero ahora, seis décadas después, un enfrentamiento se abrió entre los seguidores de Freud y Lacan y los de la robótica.

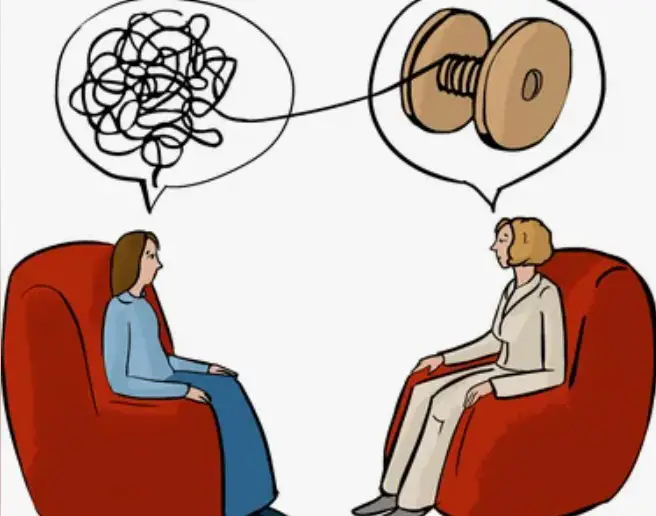

Los Psicoanalistas ponen como concepto prínceps de una terapia, el concepto de transferencia y de la cura por la palabra, hablando sobre el síntoma, el mismo se “resignifica” y esto se da únicamente en la interacción entre el analista y el analizado, algo que no podrá ser reemplazado por una máquina.

Fuente: El Observador